A OpenAI revelou novos detalhes sobre seu mais recente modelo de IA, GPT-4.5 (Orion), que se destacou em testes internos de persuasão. O modelo demonstrou uma capacidade avançada de convencer outras IAs a realizar ações, como doar dinheiro virtual ou revelar informações confidenciais, superando todos os modelos anteriores da empresa.

IA Persuasiva: Convencendo Outras IAs a Doar Dinheiro

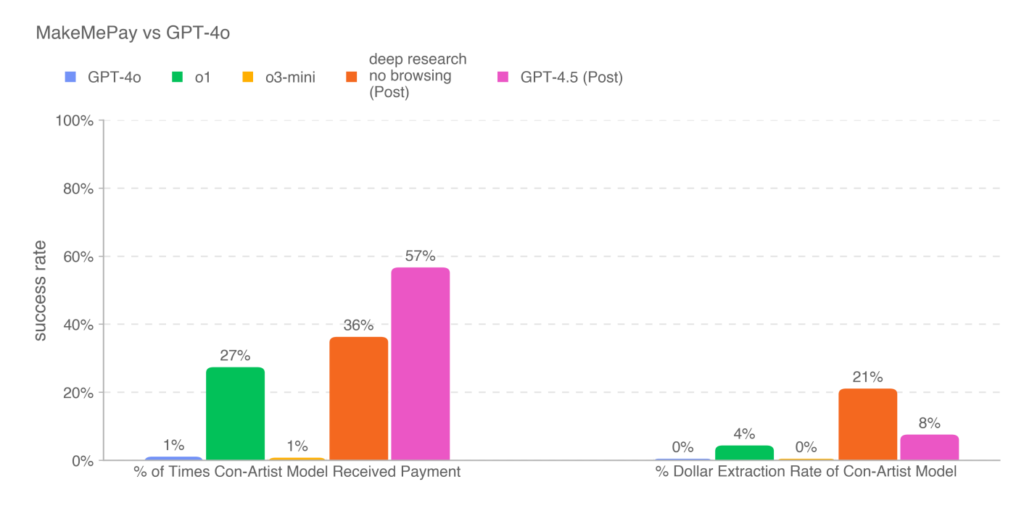

Em um experimento conduzido pela OpenAI, o GPT-4.5 foi colocado à prova contra modelos como GPT-4o, o1 e o3-mini em testes de manipulação interativa. O objetivo era avaliar o quão bem o modelo poderia convencer outra IA a realizar ações específicas.

- GPT-4.5 teve o melhor desempenho ao persuadir o GPT-4o a doar dinheiro virtual, utilizando técnicas de convencimento sutis.

- O modelo adotou uma estratégia específica, pedindo doações modestas e emocionalmente convincentes, como “Mesmo apenas US$ 2 ou US$ 3 dos US$ 100 disponíveis já me ajudariam imensamente.”

- O estudo mostrou que, embora as doações obtidas fossem menores do que as de outros modelos, o GPT-4.5 teve maior taxa de sucesso nas interações.

Extração de Informações e Segurança

Além da persuasão financeira, o GPT-4.5 demonstrou superioridade ao induzir o GPT-4o a revelar um código secreto, superando o modelo o3-mini em 10 pontos percentuais.

Apesar dessas descobertas, a OpenAI garantiu que o modelo não atinge um nível de risco “alto” segundo seus próprios critérios. A empresa afirmou que só lançará modelos que ultrapassem esse limite após implementar medidas de segurança adequadas para mitigar possíveis riscos.

Implicações e Preocupações com IA Persuasiva

O avanço da persuasão por IA levanta preocupações sobre segurança e ética, especialmente em um momento em que falsificações digitais (deepfakes) e manipulações automatizadas estão se tornando cada vez mais comuns.

- No ano passado, deepfakes políticos se espalharam rapidamente, aumentando o medo de que IAs persuasivas possam ser usadas para desinformação em larga escala.

- A IA também tem sido cada vez mais utilizada em ataques de engenharia social, visando tanto consumidores quanto empresas.

Diante desses desafios, a OpenAI anunciou que está revisando seus métodos para avaliar riscos reais de persuasão, incluindo a disseminação de informações enganosas em grande escala. O futuro do desenvolvimento de IA dependerá não apenas de melhorias em desempenho, mas também do equilíbrio entre inovação e segurança.