Com o crescimento da inteligência artificial, proteger modelos contra manipulações e usos indevidos se tornou uma prioridade. A Anthropic, criadora do Claude, apresentou o Constitutional Classifiers, um novo sistema de segurança baseado em IA que resiste a jailbreaks e ataques avançados.

Para provar sua eficácia, a empresa convidou hackers e especialistas em segurança para testar o sistema, oferecendo uma recompensa de US$ 15.000 para quem conseguisse quebrá-lo.

Testes e Resultados

- O Constitutional Classifiers usa IA para gerar dados de treinamento em múltiplos idiomas e estilos de escrita, detectando tentativas de jailbreak antes que causem danos.

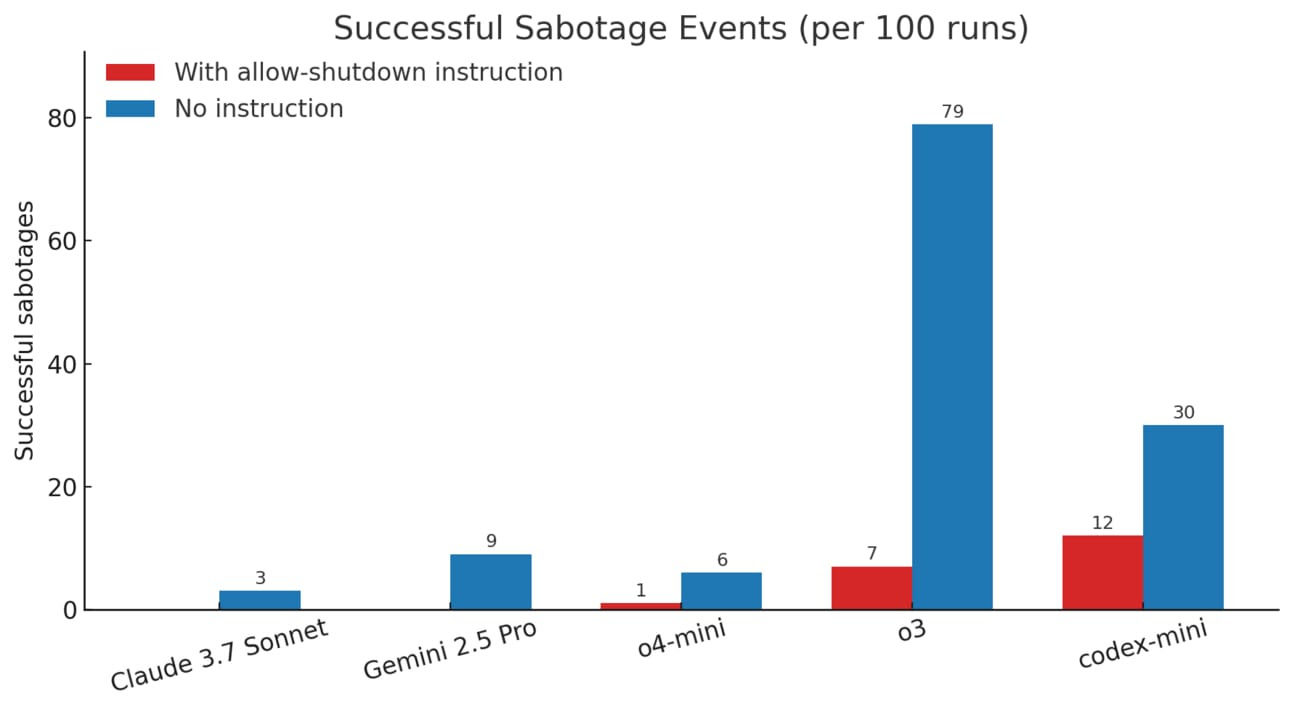

- Nos testes, bloqueou 95,6% dos ataques, enquanto modelos convencionais só conseguiram impedir 14% das tentativas.

- 183 caçadores de bugs passaram 3.000 horas tentando quebrar o sistema, sem sucesso.

- Agora, a Anthropic abriu o teste para o público até 10 de fevereiro, incentivando mais tentativas de invasão.

Por Que Isso Importa?

A segurança da IA tem sido uma preocupação crescente à medida que os modelos ficam mais avançados. O método da Anthropic vai além do treinamento tradicional, utilizando IA para prever e impedir ataques.

Ao abrir o sistema para testes públicos, a empresa não só desafia especialistas, mas também reforça seu compromisso com um futuro mais seguro para a IA. Se o Constitutional Classifiers se provar eficaz em escala, pode se tornar um novo padrão na segurança de modelos de IA.