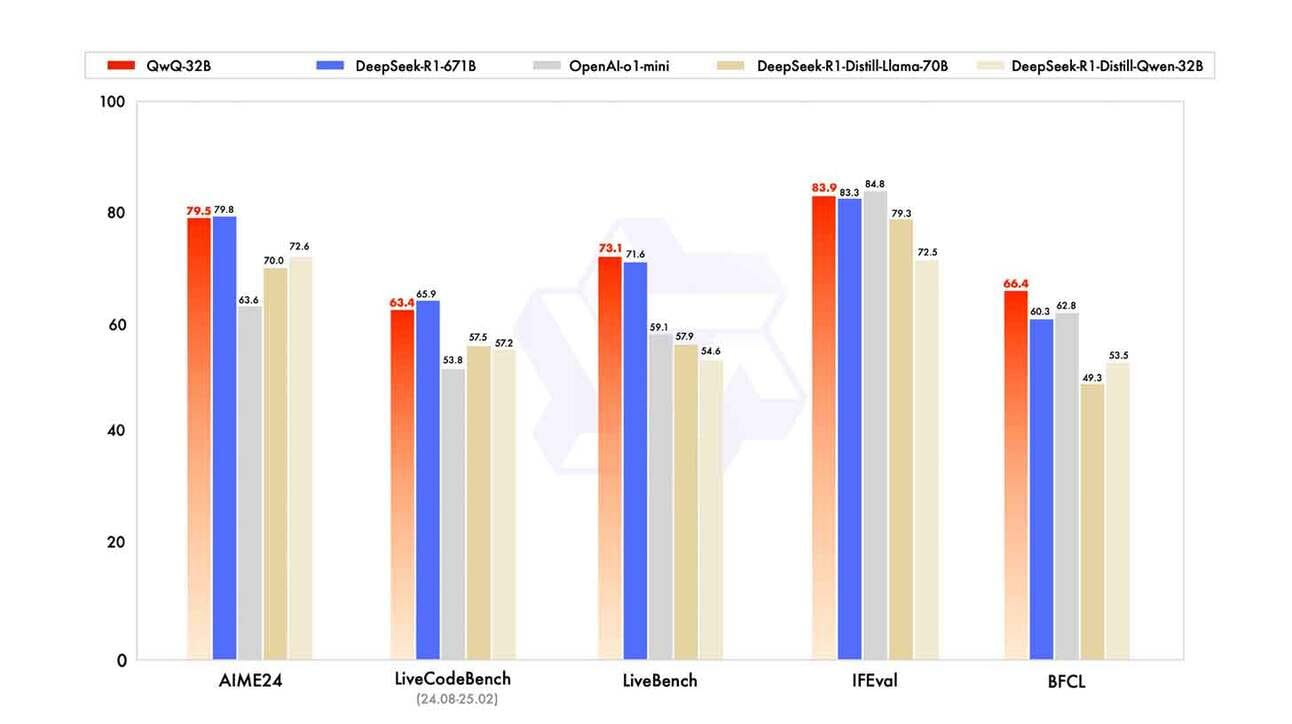

A Alibaba está acelerando sua presença na corrida da inteligência artificial, com o lançamento do QwQ-32B, um modelo de raciocínio altamente eficiente que desafia concorrentes maiores, como DeepSeek-R1, ao oferecer desempenho equivalente ou superior com uma fração do custo.

Por Que o QwQ-32B se Destaca?

O modelo se diferencia pelo uso de aprendizado por reforço em larga escala, que permite melhor desempenho em matemática, programação e tarefas de raciocínio lógico. Seus principais avanços incluem:

- Tamanho 20 vezes menor que o DeepSeek-R1, mantendo desempenho semelhante.

- Custo de apenas $0,20 por milhão de tokens de entrada e saída, uma economia de 90% em comparação com modelos de desempenho similar, como R1 e o1-mini.

- Código open-source, disponível sob a licença Apache 2.0, permitindo o uso e adaptação do modelo por desenvolvedores e empresas.

Onde o Modelo Está Disponível?

O QwQ-32B já pode ser acessado por meio das plataformas:

- Hugging Face, para experimentação e ajustes personalizados.

- Alibaba Cloud ModelScope, para implementações em grande escala.

O Futuro da IA: Eficiência x Tamanho

A chegada do QwQ-32B reforça a tendência de modelos menores e mais eficientes, desafiando a noção de que tamanho é tudo na inteligência artificial. Com China e empresas como a Alibaba apostando em arquiteturas otimizadas, o setor caminha para a viabilização de modelos de inteligência quase-fronteiriça operando localmente em dispositivos—um grande avanço rumo à inteligência artificial geral (AGI) acessível e econômica.