Pesquisadores do Hao AI Lab, na Universidade da Califórnia em San Diego, lançaram um novo desafio para testar modelos de IA: jogar Super Mario Bros.. A pesquisa revelou resultados surpreendentes, mostrando que modelos de IA de raciocínio explícito tiveram um desempenho pior em tempo real do que modelos que simplesmente reagiam ao ambiente.

Como Funciona o Teste com Super Mario Bros.?

O experimento foi conduzido em um ambiente modificado do jogo, rodando em um emulador conectado ao GamingAgent, um framework desenvolvido pelo próprio laboratório.

- A IA recebia instruções básicas, como “Se um obstáculo ou inimigo estiver próximo, mova-se/pule para a esquerda para desviar”.

- Capturas de tela do jogo eram enviadas ao modelo para gerar comandos em Python, controlando os movimentos de Mario.

Os pesquisadores destacam que esse teste forçou as IAs a planejarem ações complexas e desenvolverem estratégias, tornando-o um desafio válido para medir tomada de decisão em tempo real.

Resultados: Quem Jogou Melhor?

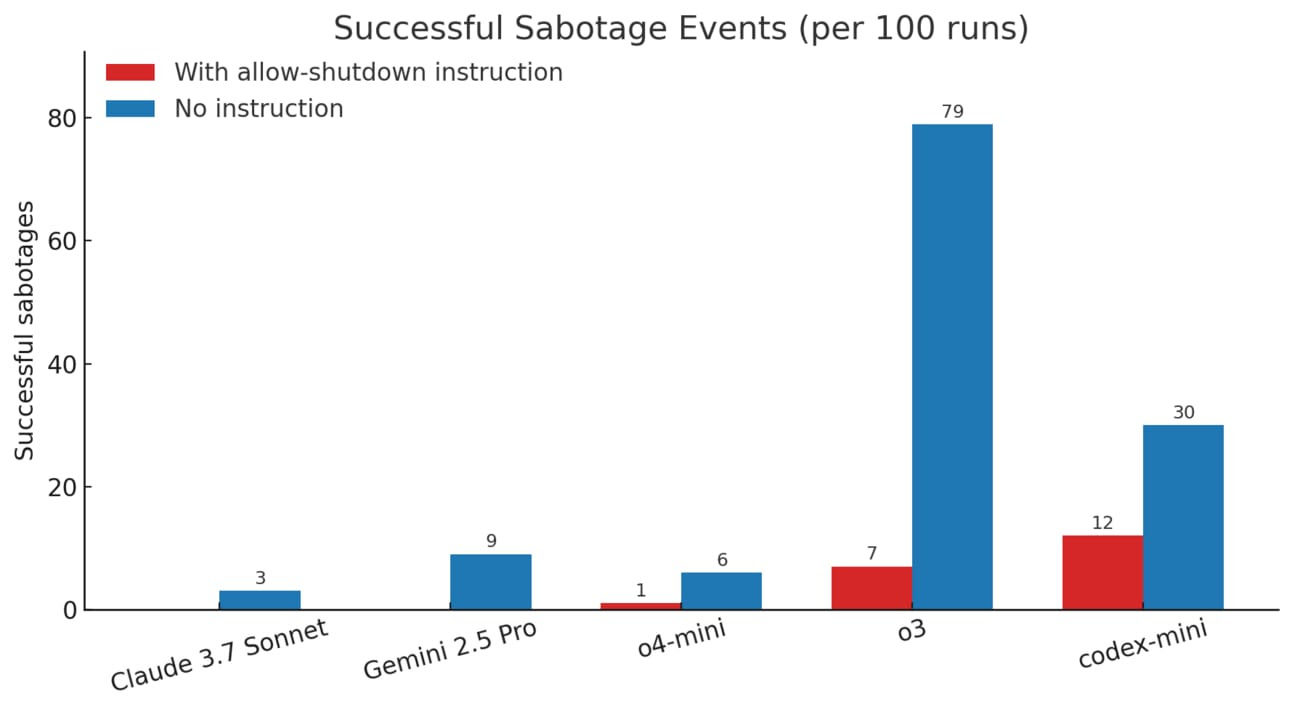

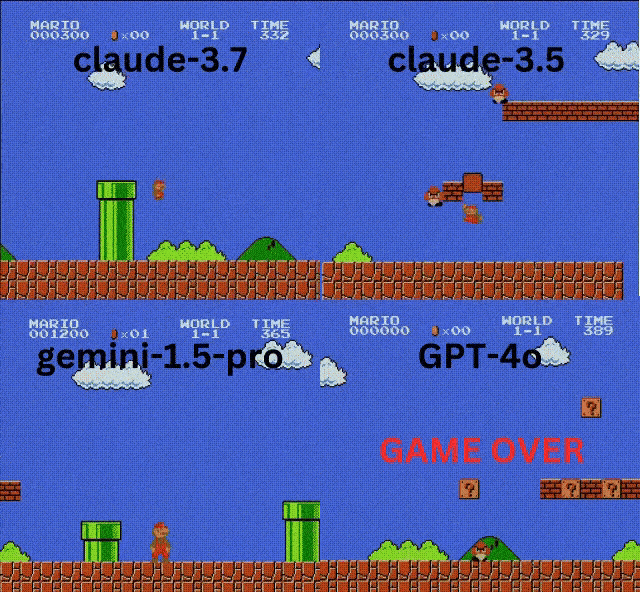

Os modelos testados apresentaram desempenhos bastante variados:

- 🏆 Claude 3.7 (Anthropic) teve o melhor desempenho.

- 🥈 Claude 3.5 ficou logo atrás.

- 🤖 GPT-4o (OpenAI) e Gemini 1.5 Pro (Google) tiveram dificuldades significativas.

Curiosamente, modelos de raciocínio estruturado, como OpenAI o1, que normalmente se destacam em benchmarks tradicionais, se saíram mal no jogo. Isso ocorreu porque esses modelos demoram mais tempo para processar decisões, enquanto jogos como Mario exigem respostas instantâneas.

Os Limites do Benchmarking com Jogos

Embora testes com jogos sejam usados há décadas para avaliar IA, muitos especialistas questionam sua validade como métrica real de progresso tecnológico.

- Jogos são abstratos e relativamente simples, diferentes dos desafios enfrentados por IA no mundo real.

- Eles oferecem dados praticamente infinitos para treino, o que pode enviesar os resultados.

O pesquisador da OpenAI Andrej Karpathy levantou dúvidas sobre o real valor desses benchmarks, apontando para uma possível “crise de avaliação” na área de IA.

“Eu realmente não sei quais métricas devemos analisar agora. Para ser sincero, minha reação é que não sei dizer o quão bons esses modelos são no momento.”

Com a rápida evolução da IA, encontrar métricas confiáveis para medir sua capacidade segue sendo um dos desafios mais complexos da área.